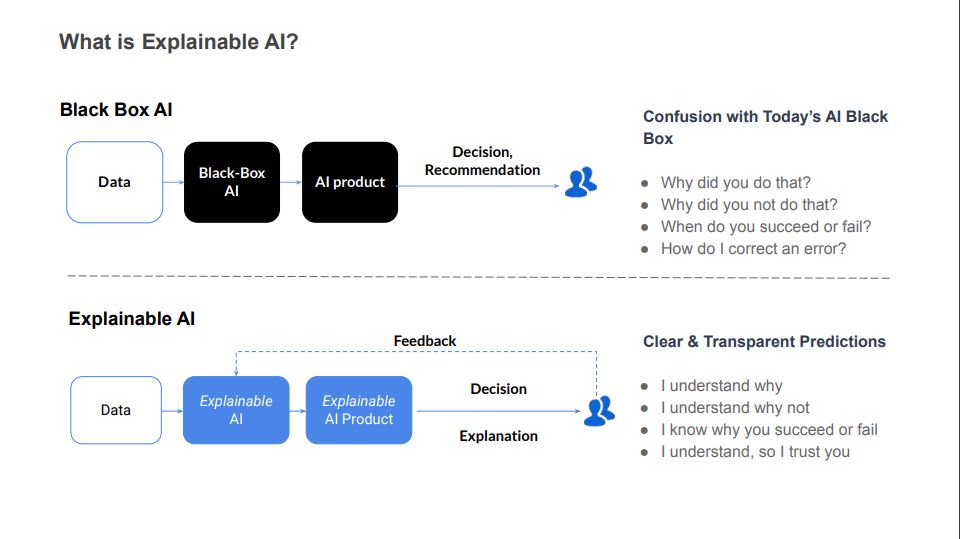

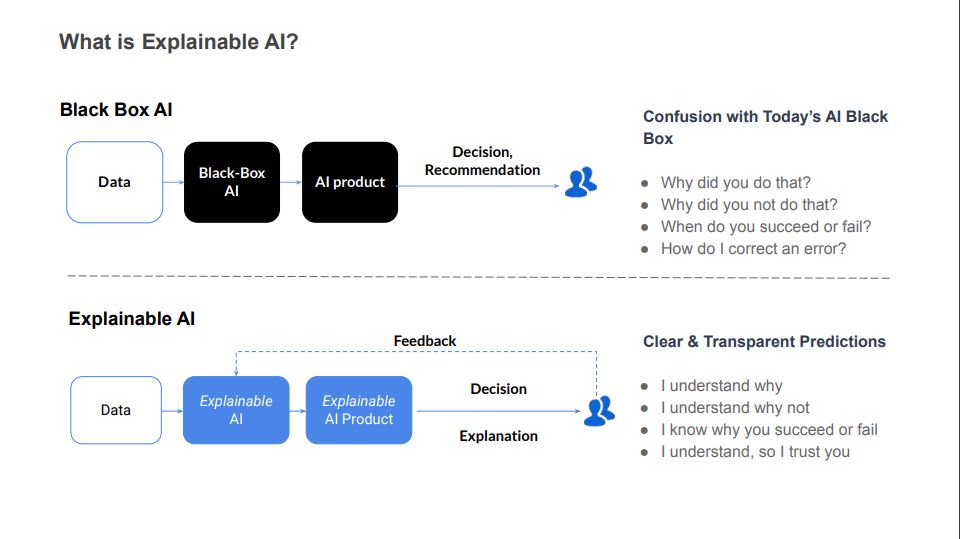

در جهانی که وابستگی به هوش مصنوعی روزبهروز در حال افزایش است توانایی فهمیدن چگونگی کارکرد و تصمیمگیری این سیستمها اهمیت بسزایی دارد. هوش مصنوعی هر روز دامنههای وسیعتری را دربرمیگیرد. در این میان ما با انواع هوش مصنوعی در دستههای مختلف روبهرو هستیم. هوش مصنوعی قابل توصیف (Explainable AI یا XAI) به فناوریهایی اطلاق میشود که نهتنها قادر به انجامدادن وظایف با دقت بالا هستند، میتوانند روند تفکر و تصمیمگیری خود را بهگونهای شفاف و فهمیدنی برای انسانها توضیح دهند. XAI به دنبال پرکردن شکاف میان عملکرد پیچیده AI و به شفافیت و قابلیت اطمینان نیاز است.

- 1. چرا Explainable AI مهم است؟

- 2. چگونگی کارکرد Explainable AI

- 3. نحوه ساخت اعتماد ازطریق هوش مصنوعی قابل توصیف

- 4. کاربردهای Explainable AI

- 5. چالشهای پیش روی Explainable AI

- 6. آینده Explainable AI

- 7. معماریهای اصلی و مدلهای XAI

- 8. نتیجهگیری

- 9. پرسشهای متداول

- 10. یادگیری هوش مصنوعی را از امروز شروع کنید!

چرا Explainable AI مهم است؟

پیش از هر چیز بد نیست که ابتدا به این پرسش پاسخ دهیم که چرا هوش مصنوعی قابل توصیف اهمیت دارد. در ادامه به مهمترین دلیلهای اهمیت XAI پرداختهایم.

افزایش شفافیت

در دنیایی که بهطور فزایندهای، الگوریتمهایی تصمیمهای مهم را میگیرند که پیچیدگی زیادی دارند شفافیت بیشتر بهمعنای درک بهتر عملکرد این الگوریتمهاست. شفافیت در XAI به کاربران امکان میدهد تا بفهمند چرا یک سیستم هوش مصنوعی به نتیجه خاصی رسیده است؛ این امر میتواند در حوزههای حساس، مانند پزشکی، قضایی و مالی، بسیار حیاتی باشد.

اعتمادسازی در میان کاربران

وقتی کاربران میتوانند بفهمند و درک کنند که چگونه یک سیستم تصمیمگیری میکند، احتمال بیشتری دارد که به آن سیستم اعتماد کنند. اعتماد کلیدی است برای پذیرش و استفاده گسترده از فناوریهای جدید. هوش مصنوعی قابل توصیف، با ارائه توضیحات قابلفهم برای تصمیمات AI، به ایجاد پلی میان پیچیدگیهای فناوری و انتظارات انسانی کمک میکند.

تسهیل رعایت مقررات و استانداردها

با توجه به رشد سریع فناوری هوش مصنوعی و نگرانیهای مرتبط با حریم خصوصی، امنیت و اخلاق، نظارت و رعایت مقررات مربوط به استفاده از این فناوریها اهمیت ویژهای یافته است. XAI با فراهمکردن شفافیت در نحوه کارکرد سیستمها، به سازمانها کمک میکند تا بهراحتی مطابقت خود با استانداردهای قانونی و اخلاقی را اثبات کنند. این امر، نهتنها به تقویت اعتماد عمومی کمک میکند، اطمینان حاصل میکند که فناوریهای AI بهشکلی مسئولانه و پایدار توسعه یابند.

چگونگی کارکرد Explainable AI

هوش مصنوعی قابل توصیف (XAI) به فناوریها و رویکردهایی اشاره میکند که به ما اجازه میدهند تا از تصمیمها و پیشبینیهای سیستمهای هوش مصنوعی درک بهتری داشته باشیم. این کار با ارائه دادههایی که بهشکل قابلفهم برای انسانها هستند انجام میشود. در این بخش، روشهای مدلسازی و ابزارها و فناوریهای موجود را بررسی میکنیم که به پیادهسازی XAI کمک میکنند.

روشهای مدلسازی

در دنیای هوش مصنوعی توصیفپذیر روشهای مدلسازی به دو دسته کلی تقسیم میشوند: مدلهای قابلتوصیف از پایه و تکنیکهای توضیحدهنده برای مدلهای موجود. مدلهای قابلتوصیف از بنیاد، مانند درختان تصمیم و قوانین قابل فهم، بهطور طبیعی شفاف هستند و فرایند تصمیمگیری آنها بهراحتی قابل درک است. از سوی دیگر، تکنیکهای توصیفکننده برای مدلهای موجود، مانند LIME (Local Interpretable Model-agnostic Explanations) و SHAP (SHapley Additive exPlanations)، امکان توصیف و توضیح تصمیمهای گرفتهشده توسط مدلهای پیچیدهتر، مانند شبکههای عصبی عمیق، را فراهم میآورند.

ابزارها و فناوریهای موجود

برای پیادهسازی و استفاده از هوش مصنوعی قابل توصیف یا XAI ابزارها و فناوریهای مختلفی وجود دارد که توسعهدهندگان و دانشمندان داده میتوانند از آنها بهره ببرند. این ابزارها کتابخانهها و پلتفرمهای نرمافزاری را دربرمیگیرند که رویکردهای قابل توصیف را در مدلسازی دادهها تسهیل میکنند؛ برای مثال، TensorFlow و PyTorch، دو کتابخانه محبوب برای یادگیری عمیق، افزونهها و ماژولهایی را ارائه میکنند که کمک میکنند تا توضیحاتی درمورد تصمیمها و پیشبینیهای مدلها ارائه شود؛ علاوهبراین ابزارهایی مانند Microsoft InterpretML و IBM Watson OpenScale پلتفرمهایی را ارائه میکنند که به کاربران اجازه میدهند تا بهطور مؤثرتری مدلهای هوش مصنوعی را تجزیهوتحلیل و تفسیر کنند.

نحوه ساخت اعتماد ازطریق هوش مصنوعی قابل توصیف

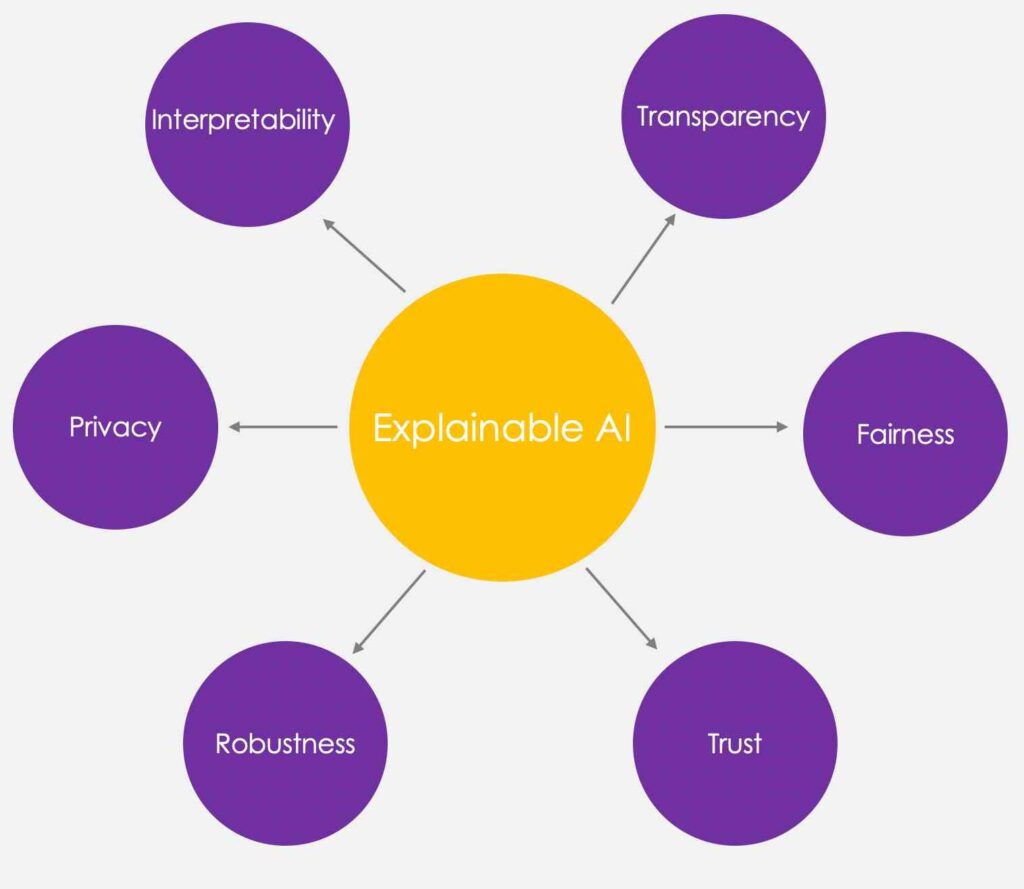

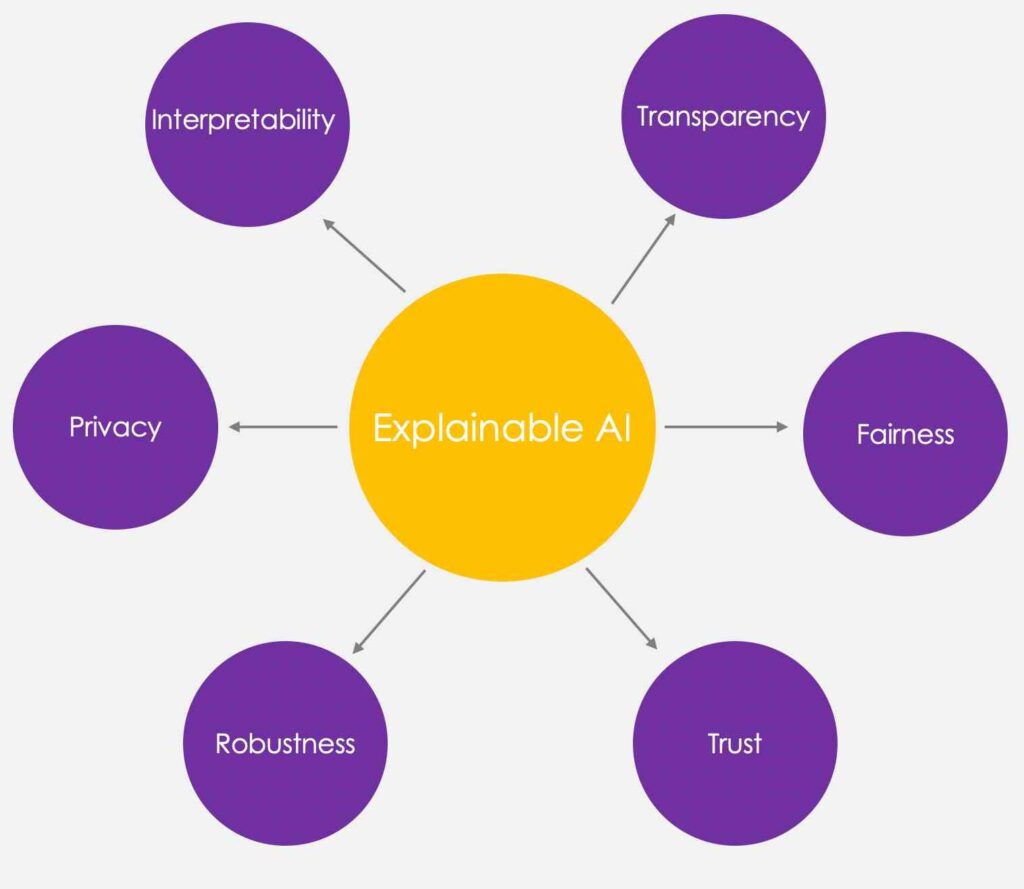

در اینجا برخی از اصول هوش مصنوعی قابل توصیف را آوردهایم که میتوانند به ساختن اعتماد کمک کنند:

- شفافیت: اطمینان از درک ذینفعان از فرایند تصمیمگیری مدلها.

- عدالت و سوگیرینداشتن: اطمینان از اینکه تصمیمهای مدلها برای همه، ازجمله افراد در گروههای محافظتشده (نژاد، دین، جنسیت، معلولیت، قومیت)، عادلانه است.

- اعتماد: ارزیابی سطح اعتماد کاربران انسانی که از سیستم AI استفاده میکنند.

- استحکام: مقاومت دربرابر تغییرات در دادههای ورودی یا پارامترهای مدل، حفظ عملکرد ثابت و قابلاعتماد حتی زمانی که با نبود قطعیت یا شرایط غیرمنتظره مواجه میشوند.

- حریم خصوصی: تضمین حفاظت از اطلاعات حساس کاربر.

- قابلیت تفسیر: ارائه توضیحات قابلفهم انسانی برای پیشبینیها و نتایج آنها.

هر یک از این روشها به موفقیت مدل کمک میکند.

کاربردهای Explainable AI

برخی از مهمترین کاربردهای هوش مصنوعی قابل توصیف از این قرار است:

پزشکی

در حوزه پزشکی Explainable AI میتواند به پزشکان کمک کند تا تشخیصهای دقیقتری ارائه کنند و درمانهای شخصیسازیشدهتری را برای بیماران خود طراحی کنند. با استفاده از XAI مدلهای پیچیدهی AI که از دادههای بزرگ بیماری برای پیشبینی بیماریها و پاسخهای درمانی استفاده میکنند قابل فهم و تفسیرپذیر میشوند. این امر به پزشکان اجازه میدهد تا درک بهتری از چرایی پیشنهادهای مدل داشته باشند و تصمیمهای آگاهانهتری بگیرند؛ برای مثال، در تشخیص سرطان XAI میتواند به توضیح دلایلی که یک مدل خاص نشانگرهای خاصی را برای تشخیص بیماری انتخاب کرده است کمک کند.

پیشنهاد میکنیم درباره کاربردهای زبان برنامهنویسی پایتون در پزشکی هم مطالعه کنید.

مالی

در بخش مالی، XAI به مؤسسات مالی امکان میدهد تا تصمیمهای اعتباری، سرمایهگذاری و مدیریت ریسک خود را شفافسازی کنند. این امر، بهویژه، در رعایت مقررات و ایجاد اعتماد در مشتریان اهمیت دارد. با توانایی توضیح چگونگی و دلایل تصمیمهای خود توسط مدلهای AI، بانکها و مؤسسات مالی میتوانند به مشتریان خود نشان دهند که چگونه امتیاز اعتباری آنها محاسبه شده یا چرا یک سرمایهگذاری خاص پیشنهاد شده است. این شفافیت میتواند به کاهش ابهام و افزایش رضایت مشتری کمک کند.

پیشنهاد میکنیم درباره ۱۰ راه برای استفاده از ChatGPT در حوزه مالی هم مطالعه کنید.

تجارت الکترونیک

در عرصه تجارت الکترونیک XAI میتواند به بهبود تجربه کاربری و افزایش فروش کمک کند. با فهم بهتری از نحوه تصمیمگیری مدلهای پیشنهاددهنده تجار میتوانند پیشنهادهای شخصیسازیشدهتر و مؤثرتری به مشتریان خود ارائه کنند؛ علاوهبراین شفافیت در نحوه جمعآوری و استفاده از دادههای کاربران میتواند به افزایش اعتماد و وفاداری مشتریان کمک کند.

همچنین XAI در تجارت الکترونیک میتواند در تحلیل رفتار مشتریان و بهینهسازی استراتژیهای بازاریابی نقش مهمی ایفا کند.

چالشهای پیش روی Explainable AI

پیشرفتهای اخیر در زمینه هوش مصنوعی (AI) و بهخصوص Explainable AI (XAI) افقهای جدیدی را در فهم و تحلیل تصمیمگیریهای ماشینی گشودهاند؛ بااینحال همزمان با این پیشرفتها چالشهایی نیز در مسیر توسعه و پیادهسازی XAI ظاهر شدهاند که محدودیتهای فنی و مسائل اخلاقی و حقوقی را دربرمیگیرند.

محدودیتهای فنی

یکی از بزرگترین چالشهای پیش روی XAI محدودیتهای فنی است. مدلهای هوش مصنوعی، بهویژه آنهایی که از شبکههای عصبی عمیق استفاده میکنند، میتوانند بسیار پیچیده و غیرقابل فهم برای افراد غیرمتخصص باشند. این پیچیدگی فنی فهم و توضیح دادههایی را که بر تصمیمگیریهای مدل تأثیر میگذارند دشوار میکند؛ علاوهبراین برخی از مدلها ممکن است بهدلیل ساختارهای غیرخطی و تعداد زیاد پارامترها، در تولید توضیحات دقیق و قابل فهم برای انسانها ناتوان باشند. این محدودیتها نیازمند تحقیقات و توسعه بیشتر در زمینه الگوریتمها و ابزارهایی هستند که میتوانند پیچیدگیهای فنی را بهشکلی قابلفهم تبدیل کنند.

مسائل اخلاقی و حقوقی

مسئله دیگری که در مسیر توسعه XAI وجود دارد به جنبههای اخلاقی و حقوقی مربوط است. با افزایش استفاده از AI در تصمیمگیریهای مهم و حساس نیاز به شفافیت و قابلیت پاسخگویی در این سیستمها بیشازپیش احساس میشود. این امر، بهویژه، در زمینههایی مانند پزشکی، قضایی و مالی که تصمیمات میتوانند تأثیرات قابل توجهی بر زندگی افراد بگذارد حائز اهمیت است.

بهعلاوه، مسائل مربوط به حریم خصوصی دادهها، تبعیض و بیطرفی نیز باید در نظر گرفته شوند. توسعهدهندگان و پژوهشگران XAI باید مطمئن شوند که سیستمهایی که طراحی میکنند، از اصول اخلاقی پیروی و قوانینومقررات مربوط به حفاظت از دادهها و حقوق بشر را رعایت میکنند. این امر مستلزم یک رویکرد چندبعدی است که نهتنها جنبههای فنی، جنبههای اجتماعی، اخلاقی و حقوقی را نیز در بر میگیرد.

آینده Explainable AI

هوش مصنوعی قابل توصیف یا XAI پیشرفتهای بسیار زیادی کرده و قدمهای بلندی را برداشته است. بد نیست نگاهی به آینده این مدل بیندازیم.

پیشبینیها و روندها

در آینده پیشبینی میشود که Explainable AI (XAI) نقشی محوری در توسعه فناوریهای هوش مصنوعی ایفا کند. با افزایش توجه به اخلاقیات در AI و نیاز به سیستمهای قابلفهم و شفاف، XAI بهعنوان یک ضرورت برای پیشرفت پایدار در عرصه فناوری شناخته میشود.

انتظار میرود که روندهای آینده شامل توسعه روشها و ابزارهای جدید برای تسهیل فهم بهتر مدلهای AI باشد، بهطوری که حتی افراد غیرمتخصص نیز قادر به درک تصمیمها و پیشبینیهای انجامشده توسط این سیستمها باشند.

یکی از روندهای کلیدی ادغام XAI در سیستمهای هوش مصنوعی مورداستفاده روزمره، از خودروهای خودران گرفته تا سیستمهای توصیهگر آنلاین، است. این امر به کاربران کمک میکند تا بهتر درک کنند چگونه این سیستمها کار میکنند و براساس چه اطلاعاتی تصمیمگیری میکنند. علاوهبراین پیشبینی میشود روشهای نوینی در XAI ظهور کنند که امکان ارائه توضیحات دقیقتر و درعینحال قابل فهمتری را فراهم میآورند.

نقش هوش مصنوعی قابل توصیف در توسعه AI پایدار

XAI یک عنصر حیاتی در توسعه AI پایدار محسوب میشود. با افزایش شفافیت و فهمپذیری، XAI میتواند به کاهش نگرانیهای اجتماعی و اخلاقی مرتبط با استفاده از AI کمک کند. این امر، بهنوبه خود، میتواند به پذیرش گستردهتر فناوریهای هوش مصنوعی بینجامد؛ زیرا افراد و سازمانها به تواناییهای این فناوریها برای انجامدادن وظایف به شیوهای اخلاقی و قابل پاسخگویی اعتماد خواهند کرد.

علاوهبراین XAI میتواند در حل چالشهای پیچیده محیطی و اجتماعی مؤثر باشد؛ برای مثال، در زمینه تغییرات اقلیمی مدلهای AI که قادر به ارائه توضیحاتی درمورد پیشبینیهای خود هستند میتوانند به تصمیمگیرندگان کمک کنند تا استراتژیهای مقابلهای مبتنی بر دادهها را توسعه دهند؛ همچنین در حوزه بهداشت و درمان XAI میتواند به پزشکان کمک کند تصمیمهای دقیقتری براساس تجزیهوتحلیل دادههای پیچیده بگیرند.

درنهایت، XAI بهعنوان پلی میان توسعه فناوری هوش مصنوعی و نیازهای اجتماعی و اخلاقی عمل میکند. با توجه به اهمیت روزافزون AI در جوامع مدرن، توسعه و پیادهسازی XAI بهشیوهای پایدار امری ضروری است. این رویکرد، نهتنها به بهبود شفافیت و اعتماد به فناوری کمک میکند، بلکه زمینهساز پیشرفتهایی است که همگام با ارزشها و نیازهای انسانی پیش میرود.

معماریهای اصلی و مدلهای XAI

XAI به روشها و تکنیکهایی اشاره میکند که به ما اجازه میدهند فرایندهای درونی مدلهای AI را درک و تفسیر کنیم. این امر ازطریق چندین معماری و مدل مختلف امکانپذیر است، ازجمله:

- مدلهای مبتنی بر قواعد: این مدلها تصمیمگیریهای خود را براساس مجموعهای از قوانین منطقی انجام میدهند که برای انسانها بهراحتی قابلفهم و تفسیر هستند.

- مدلهای شفاف: برخی از مدلها، مانند درختان تصمیم و مدلهای خطی، بهطور طبیعی قابلتفسیر هستند؛ زیرا نحوه تصمیمگیری در آنها مستقیماً قابل مشاهده است.

- تکنیکهای پستفسیری: برای مدلهای پیچیدهتر که بهطور طبیعی قابل تفسیر نیستند، تکنیکهای پستفسیری، مانند LIME یا SHAP، استفاده میشوند تا توضیحاتی را برای تصمیمات اتخاذشده توسط مدل فراهم آورند.

این موارد فقط سه مورد از اصلیترین معماریهای مدلهای XAI است.

نتیجهگیری

در دنیایی که بهسرعت بهسمت دیجیتالیزهشدن پیش میرود وجود فناوریهایی مانند Explainable AI (XAI) اهمیت فزایندهای یافته است. XAI، نهتنها فرصتهای جدیدی را در زمینه شفافیت و قابلیت فهمپذیری هوش مصنوعی ارائه میکند، میتواند به ایجاد اعتماد بیشتر میان کاربران و این سیستمهای پیچیده کمک کند. با توجه به اینکه هوش مصنوعی در حال حاضر نقش بسیار مهمی در بسیاری از جنبههای زندگی روزمره و حرفهای ما ایفا میکند، اهمیت XAI بیشازپیش آشکار میشود.

توسعه و پیادهسازی XAI میتواند به ایجاد جوامعی هوشمندتر، مسئولیتپذیرتر و شفافتر بینجامد که در آن افراد میتوانند با درک بهتری از فناوریهایی که زندگیشان را شکل میدهند، تصمیمهای آگاهانهتری بگیرند. XAI، نهتنها یک پل میان انسان و ماشین است، گامی مهم بهسمت فهم بهتر و مسئولیتپذیری در عصر دیجیتال محسوب میشود.

پرسشهای متداول

Explainable AI چگونه به افزایش اعتماد کمک میکند؟

XAI با ارائه شفافیت و قابلیت فهم در نحوه کارکرد و تصمیمگیریهای سیستمهای AI به کاربران کمک میکند درک بهتری از این فناوریها داشته باشند و درنتیجه اعتماد بیشتری به آنها نشان دهند.

آیا Explainable AI میتواند بهطور کامل شفاف باشد؟

در حالی که هدف XAI ارائه حداکثر شفافیت است، ممکن است در برخی موارد، به دلایل فنی یا امنیتی، دستیابی به شفافیت کامل محدود باشد. با این حال، پیشرفتهای مستمر در این زمینه به بهبود شفافیت کمک میکند.

چه نوع کسبوکارهایی بیشترین سود را از Explainable AI میبرند؟

کسبوکارهایی که در زمینههای حساس، مانند پزشکی، مالی و قضایی، فعالیت میکنند میتوانند از مزیتهای XAI بهشکل قابل توجهی بهرهمند شوند؛ زیرا شفافیت و قابلیت اعتماد در این حوزهها از اهمیت بالایی برخوردار است.

چگونه میتوان با چالشهای اخلاقی مرتبط با Explainable AI مقابله کرد؟

مقابله با چالشهای اخلاقی مرتبط با XAI نیازمند توجه به اصول اخلاقی در توسعه و کاربرد AI، ازجمله شفافیت، عدالت و مسئولیتپذیری، است؛ همچنین مشارکت سیاستگذاران و نهادهای نظارتی برای تعیین استانداردها و قوانین ضروری است.

آینده Explainable AI چگونه خواهد بود؟

به نظر میرسد XAI آینده روبهرشدی دارد، با توجه به افزایش تقاضا برای شفافیت و قابلیت فهم در فناوریهای AI. پیشرفتهای فنی و تحقیقاتی در این زمینه به احتمال زیاد شفافیت و قابلیت اعتماد را به سطح جدیدی خواهند برد و درنتیجه، نقش مهمی در پیشبرد فناوری پایدار و اخلاقی ایفا خواهند کرد.

یادگیری هوش مصنوعی را از امروز شروع کنید!

دنیای دادهها جذاب است و دانستن علم داده، توانایی تحلیل داده یا بازاریابی مبتنی بر داده شما را برای فرصتهای شغلی بسیاری مناسب میکند. فارغ از رشته و پیشزمینه تحصیلی یا شغلیتان، میتوانید یادگیری دیتا ساینس را همین حالا شروع کنید و این دانش را از سطح مقدماتی تا پیشرفته بیاموزید. اگر دوست دارید به این حوزه وارد شوید، پیشنهاد میکنیم با کلیک روی این لینک قدم اول را بردارید.

مشاوران کافهتدریس به شما کمک میکنند مسیر یادگیری برای ورود به این حوزه را شروع کنید:

دو مورد از دلایل مهم بودن Explainable AI را توضیح دهید.

افزایش شفافیت: در دنیایی که بهطور فزایندهای، الگوریتمهایی تصمیمهای مهم را میگیرند که پیچیدگی زیادی دارند شفافیت بیشتر بهمعنای درک بهتر عملکرد این الگوریتمهاست. شفافیت در XAI به کاربران امکان میدهد تا بفهمند چرا یک سیستم هوش مصنوعی به نتیجه خاصی رسیده است؛ این امر میتواند در حوزههای حساس، مانند پزشکی، قضایی و مالی، بسیار حیاتی باشد.

اعتمادسازی در میان کاربران: وقتی کاربران میتوانند بفهمند و درک کنند که چگونه یک سیستم تصمیمگیری میکند، احتمال بیشتری دارد که به آن سیستم اعتماد کنند. اعتماد کلیدی است برای پذیرش و استفاده گسترده از فناوریهای جدید. هوش مصنوعی قابل توصیف، با ارائه توضیحات قابلفهم برای تصمیمات AI، به ایجاد پلی میان پیچیدگیهای فناوری و انتظارات انسانی کمک میکند.

هوش مصنوعی قابل توصیف چگونه به تجارت الکترونیک کمک میکند؟

در عرصه تجارت الکترونیک XAI میتواند به بهبود تجربه کاربری و افزایش فروش کمک کند. با فهم بهتری از نحوه تصمیمگیری مدلهای پیشنهاددهنده تجار میتوانند پیشنهادهای شخصیسازیشدهتر و مؤثرتری به مشتریان خود ارائه کنند؛ علاوهبراین شفافیت در نحوه جمعآوری و استفاده از دادههای کاربران میتواند به افزایش اعتماد و وفاداری مشتریان کمک کند.

همچنین XAI در تجارت الکترونیک میتواند در تحلیل رفتار مشتریان و بهینهسازی استراتژیهای بازاریابی نقش مهمی ایفا کند.

سه مورد از اصلیترین معماریهای مدلهای XAI نام ببرید و یک مورد را توضیح دهید.

مدلهای مبتنی بر قواعد

مدلهای شفاف

تکنیکهای پستفسیری: برای مدلهای پیچیدهتر که بهطور طبیعی قابل تفسیر نیستند، تکنیکهای پستفسیری، مانند LIME یا SHAP، استفاده میشوند تا توضیحاتی را برای تصمیمات اتخاذشده توسط مدل فراهم آورند.

دو مورد از دلایل مهم بودن Explainable AI را توضیح دهید.

افزایش شفافیت

اعتمادسازی در میان کاربران

هوش مصنوعی قابل توصیف چگونه به تجارت الکترونیک کمک میکند؟

در عرصه تجارت الکترونیک XAI میتواند به بهبود تجربه کاربری و افزایش فروش کمک کند. با فهم بهتری از نحوه تصمیمگیری مدلهای پیشنهاددهنده تجار میتوانند پیشنهادهای شخصیسازیشدهتر و مؤثرتری به مشتریان خود ارائه کنند؛ علاوهبراین شفافیت در نحوه جمعآوری و استفاده از دادههای کاربران میتواند به افزایش اعتماد و وفاداری مشتریان کمک کند.همچنین XAI در تجارت الکترونیک میتواند در تحلیل رفتار مشتریان و بهینهسازی استراتژیهای بازاریابی نقش مهمی ایفا کند.

سه مورد از اصلیترین معماریهای مدلهای XAI نام ببرید و یک مورد را توضیح دهید.

مدلهای مبتنی بر قواعد: این مدلها تصمیمگیریهای خود را براساس مجموعهای از قوانین منطقی انجام میدهند که برای انسانها بهراحتی قابلفهم و تفسیر هستند.

مدلهای شفاف

تکنیکهای پستفسیری