در این مقاله از برترین LLMهای منبع باز و کاربرد بهترین مدلهای بزرگ زبانی را بررسی کردهایم. اگرچه فقط یک سال از راهاندازی ChatGPT و محبوبیت LLMهای (انحصاری) میگذرد، جامعه منبعباز در حال حاضر دستاوردهای مهمی را در زمینه LLM منبع باز به دست آورده است.

- 1. آشنایی با مدلهای زبانی بزرگ

- 2. مزایای استفاده از مدلهای زبانی بزرگ منبعباز

- 3. مزایای استفاده از مدلهای زبانی بزرگ در ابر

- 4. معایب استفاده از مدلهای زبانی بزرگ در ابر

- 5. مزایای اجرای مدلهای زبانی بزرگ بهصورت محلی

- 6. معایب اجرای مدلهای زبانی بزرگ بهصورت محلی

- 7. عوامل مهم نحوه مستقرسازی هوش مصنوعی مولد

- 8. ۸ مدل زبانی بزرگ منبع باز برتر برای سال ۲۰۲۴

- 9. انتخاب مناسبترین LLM براساس نیازهای شما

- 10. نتیجهگیری

-

11.

پرسشهای متداول

- 11.1. چرا استفاده از LLMهای منبع باز برای کسبوکارها توصیه میشود؟

- 11.2. چگونه LLMهای منبع باز به حفظ حریم خصوصی کمک میکنند؟

- 11.3. چه تفاوتهایی میان LLMهای منبع باز و مدلهای انحصاری وجود دارد؟

- 11.4. چگونه میتوان از LLMهای منبع باز برای نوآوری در هوش مصنوعی بهره برد؟

- 11.5. چه چالشهایی در استفاده از LLMهای منبع باز وجود دارد و چگونه میتوان آنها را مدیریت کرد؟

- 12. یادگیری ماشین لرنینگ را از امروز شروع کنید!

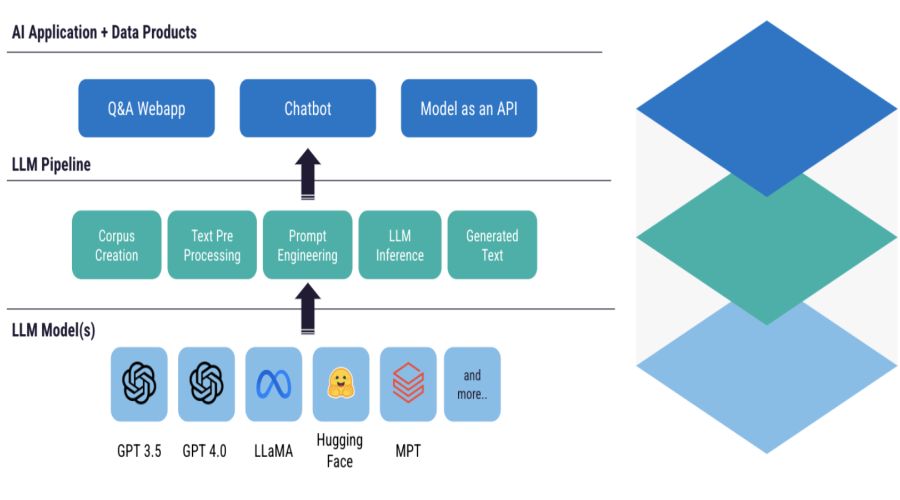

آشنایی با مدلهای زبانی بزرگ

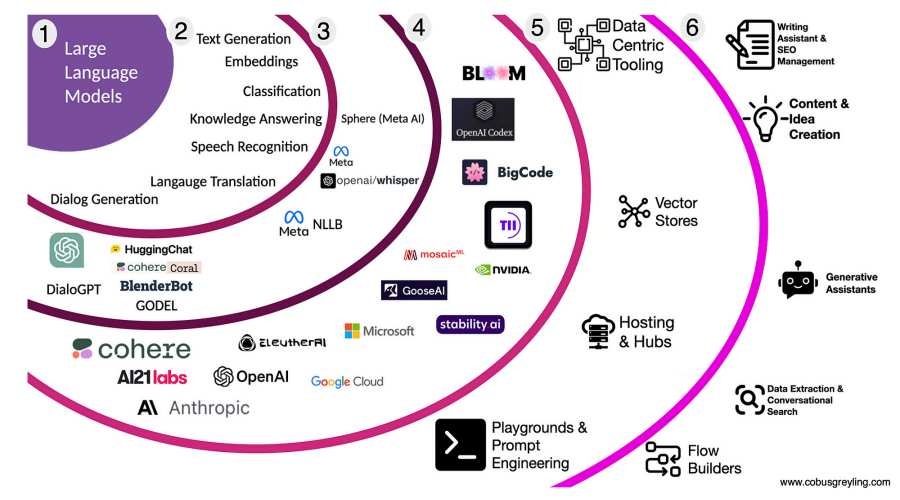

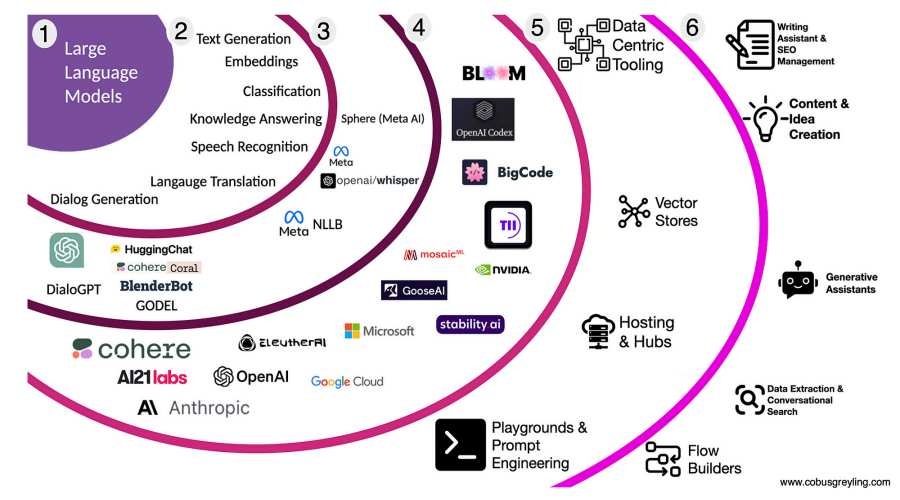

انقلاب فعلی هوش مصنوعی مولد بدون مدلهای زبانی بزرگ (LLMs) ممکن نبود. بر پایه معماری قدرتمندی بهنام ترانسفورمرها LLMها به وجود آمدند. LLMها سیستمهای AI هستند که برای مدلسازی و پردازش زبان انسانی به کار میروند. آنها «بزرگ» خوانده میشوند، زیرا صدها میلیون یا حتی میلیاردها پارامتر دارند که با استفاده از مجموعهای عظیم از دادههای متنی آموزش داده شدهاند.

ChatGPT و Gemini و بسیاری دیگر از چتباتهای محبوب این اشتراک را دارند که LLMهای زیربناییشان انحصاری است، بهاین معنی که متعلق به یک شرکت هستند و فقط پس از خرید اشتراک توسط مشتریان قابلاستفادهاند.

بااینحال یک جنبش موازی در فضای LLM بهسرعت در حال پیشروی است: LLMهای منبع باز. با توجه به نگرانیهای فزاینده درمورد نبود شفافیت و دسترسی محدود LLMهای انحصاری که عمدتاً توسط غولهای فناوری مانند مایکروسافت، گوگل و متا کنترل میشوند، LLMهای منبع باز وعده میدهند که زمینه رشد سریع LMMها و هوش مصنوعی مولد را دردسترستر، شفافتر و نوآورانهتر کنند.

مزایای استفاده از مدلهای زبانی بزرگ منبعباز

استفاده از مدلهای زبانی بزرگ منبع باز (LLMs)، بهجای نمونههای اختصاصی، مزایای متعددی دارد. در اینجا فهرستی از دلیلهای مهم آورده شده است:

تقویت امنیت دادهها و محافظت از حریم شخصی

یکی از مهمترین دغدغهها هنگام استفاده از مدلهای زبانی بزرگ اختصاصی مسئله نشتی اطلاعات یا دسترسیهای غیرمجاز به دادههای حساس توسط ارائهکنندگان این سیستمهاست. درحقیقت، تابهحال شاهد مواردی بودهایم که در آنها استفاده نادرست از اطلاعات شخصی و محرمانه برای آموزش سیستمها سروصدای زیادی به پا کرده است.

با بهکارگیری مدلهای منبع باز شرکتها بهطور کامل مسئولیت حفاظت از دادههای شخصی را بر عهده میگیرند. این امر به آنها امکان میدهد تا کنترل بهتر و بیشتری بر اطلاعات خود داشته باشند.

صرفهجویی در هزینهها و کاهش وابستگی

بیشتر LLMهای اختصاصی نیازمند خرید اشترااک برای استفاده هستند. در بلندمدت این میتواند هزینهای چشمگیر داشته باشد که برخی شرکتها، بهخصوص کسبوکارهای کوچک و متوسط، ممکن است قادر به پرداخت آن نباشند. این مورد درباره LLMهای منبعباز صدق نمیکند؛ زیرا معمولاً استفاده از آنها رایگان است.

بااینحال مهم است توجه کنیم که اجرای LLMها منابع قابلتوجهی را میطلبد. شما معمولاً باید هزینه استفاده از خدمات ابری یا زیرساختهای قدرتمند را پرداخت کنید.

شفافیت کد و سفارشیسازی مدل زبانی

دسترسی به کدها و امکان سفارشیسازی مدلهای زبانی، نهتنها پنجرهای بهسوی شفافیت میگشاید، بستری برای نوآوری و خلاقیت فراهم میآورد. شرکتهایی که به سراغ مدلهای زبانی بزرگ و متنباز روی میآورند این فرصت را خواهند داشت که از نزدیک با معماری، کد منبع، دادههای آموزشی و فرایندهای آموزش و استنباط این سیستمها آشنا شوند. این امکان دریچهای بهسوی بررسی دقیقتر است و زمینهساز سفارشیسازی براساس نیازهای خاص هر شرکت میشود.

در دنیایی که LLMهای متنباز برای عموم قابل دسترسی هستند، هر سازمانی میتواند این مدلها را برای پروژهها و کاربردهای ویژه خود تنظیم و تطبیق دهد.

پشتیبانی فعال از سمت جامعه و تقویت جریان نوآوری

جنبش متنباز قول داده است که استفاده و دسترسی به فناوریهای LLM و هوش مصنوعی مولد را دموکراتیک کند. اجازهدادن به توسعهدهندگان برای بررسی عمیقتر LLMها کلیدی برای توسعه آینده این فناوری است. با کاهش موانع ورود برای برنامهنویسان سراسر جهان، LLMهای متنباز میتوانند نوآوری را ترویج دهند و با کاهش سوگیریها و افزایش دقت و عملکرد کلی، مدلها را بهبود بخشند.

LLMهای متن باز را میتوان نمادی از انقلاب لینوکس در دنیای نرمافزار دانست. همانند لینوکس که با فلسفه متنباز خود، پایهریز انجمنهای گسترده و پرشور شده و به ایجاد نسخههای متنوع و نامداری انجامیده است، LLMهای متنباز نیز در آستانهی ایجاد تحولات مشابهی هستند.

لینوکس بهعنوان یکی از محبوبترین سیستمهای عامل در قلب جامعه فناوری جای دارد و با پشتوانهی جامعهای پرتلاش، موفق به جلب توجه و ارتقای دائمی شده است. این در حالی است که سیستم عاملهای تجاری نظیر ویندوز و MacOS بیشتر بر جذب مشتری و سودآوری متمرکز هستند، بدون آنکه چنین پشتوانهی قوی از جامعهی کاربری و توسعهدهنده را داشته باشند.

مقابله با اثرات زیستمحیطی هوش مصنوعی

در پی گسترش استفاده از LLMها دغدغههایی درباره ردپای کربنی و مصرف آب لازم برای اجرای این فناوریها مطرح شده است. اطلاعات اندکی در مورد منابع موردنیاز برای آموزش و بهکارگیری این سیستمها توسط شرکتهای دارنده انحصاری منتشر میشود، بهویژه در زمینه اثرات زیستمحیطی آنها.

با بهرهگیری از LLMهای متنباز پژوهشگران فرصت بیشتری برای کسب اطلاعات دقیقتری دارند که میتواند راه را برای پیشرفتهای جدید در جهت کاهش اثرات زیستمحیطی هوش مصنوعی هموار کند.

مزایای استفاده از مدلهای زبانی بزرگ در ابر

بیایید به برخی از مزایای استفاده از هوش مصنوعی مولد در ابر نگاهی بیندازیم:

قابلیت ارتقا

آموزش و استقرار هوش مصنوعی مولد نیازمند منابع محاسباتی گسترده و ذخیرهسازی دادههاست. گاهی فرایندهای آموزشی نیازمند چندین نمونه از GPUهای پیشرفته هستند که فقط ازطریق خدمات مبتنی بر ابر که منابع قابل مقیاسپذیری را بهصورت درخواستی ارائه میکنند برآوردهشدنی است.

کاهش هزینه

اگر شما فاقد سختافزار پیشرفته برای اجرای هوش مصنوعی مولد هستید، انتخاب ابر میتواند گزینهای مقرونبهصرفهتر باشد. با خدمات ابری، شما فقط برای منابعی که مصرف میکنید پرداخت میکنید (Pay As You Go) و اغلب GPUها و CPUها با نرخهای مقرونبهصرفهتری در دسترس هستند.

سهولت استفاده

پلتفرم ابری مجموعهای از APIها، ابزارها و فریمورکهای زبانی را ارائه میکند که فرایند ساخت، آموزش و استقرار مدلهای یادگیری ماشینی را بهشدت ساده میکند.

خدمات مدیریتی

ارائهدهندگان ابری مسئولیت راهاندازی، نگهداری، امنیت و بهینهسازی زیرساختها را بر عهده دارند که بهطور چشمگیری بار عملیاتی کاربران را کاهش میدهد.

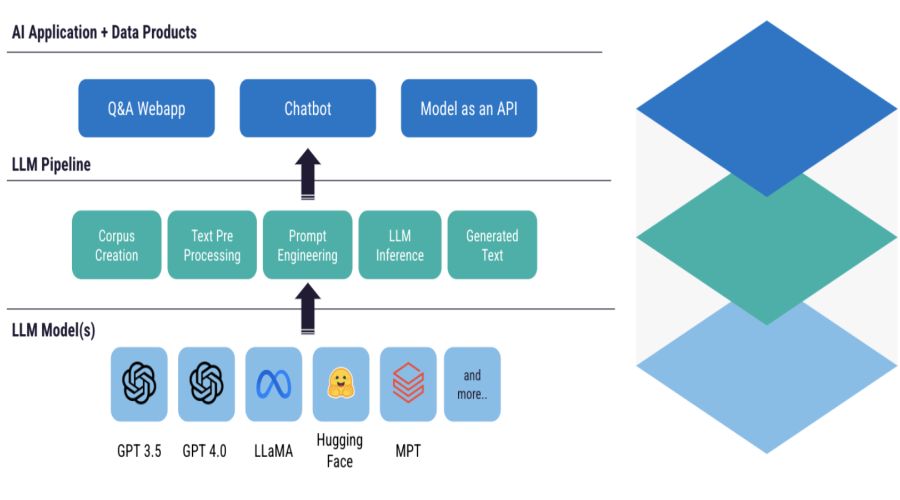

مدلهای آموزشدیده پیشین

پلتفرمهای ابری اکنون دسترسی به جدیدترین مدلهای زبانی بزرگ آموزشدیده را ارائه میکنند که میتوانند روی مجموعه دادههای سفارشی تنظیم شوند و بهراحتی در ابر مستقر شوند. این امر میتواند برای ایجاد یک خط لوله یادگیری ماشین (ML Pipeline) از ابتدا تا انتها بسیار مفید باشد.

پلتفرمهای ابری که ابزارها و مدلهای آموزشدیده را ارائه میدهند از این قرارند:

NVIDIA: NeMo Large Language Models (LLM) Cloud Service

Hugging Face: Inference Endpoints

AWS: Amazon Titan

MosaicML: Inference

Paperspace: The GPU cloud built for Machine Learning

معایب استفاده از مدلهای زبانی بزرگ در ابر

همانند هر فناوری دیگری، استفاده از مدلهای زبانی بزرگ در ابر نیز معایبی دارد:

ازدستدادن کنترل

هنگام استفاده از خدمات مدیریتشده ابری ML، شما کنترل و دید کمتری بر زیرساخت و پیادهسازی خواهید داشت.

انحصار نزد تأمینکننده

اگر مدلهای زبانی بزرگ را روی یک پلتفرم ابری آموزش دادهاید، انتقال آن به پلتفرم متفاوت دشوار خواهد بود؛ علاوهبراین وابستگی صرف به یک تامینکننده ابری، خطرات ذاتی را درمورد تغییرات سیاست و قیمت به همراه دارد.

حریم خصوصی و امنیت دادهها

دادههای شما روی سرورهای تامینکننده ابری در نقاط مختلف جهان قرار دارد؛ بنابراین باید اطمینان حاصل کنید که دادههای شما را امن نگه دارند.

هزینههای بالا

آموزش و اجرای مدلهای زبانی بزرگ در مقیاس بزرگ در هر حالتی بسیار گران است. هزینههای منابع محاسباتی و ذخیرهسازی میتواند با گذشت زمان افزایش یابد.

تأخیر در شبکه

تأخیرهایی هنگام ارتباط با مدلهایی که در ابر اجرا میشوند وجود دارد که آن را برای برنامههای بلادرنگ کمتر ایدهآل میکند.

مزایای اجرای مدلهای زبانی بزرگ بهصورت محلی

حالا که فواید و معایب اجرای مدلهای زبانی بزرگ در ابر را بررسی کردیم، بیایید به همان نکات درمورد اجرای آنها بهصورت Locally نگاه کنیم. مزایا شامل موارد زیر است:

کنترل بیشتر

شما کنترل بیشتری بر سختافزار، مدل آموزشدیده، دادهها و نرمافزاری دارید که برای اجرای سرویس استفاده میکنید. میتوانید تنظیمات را مطابق با قوانین خاص، بهینهسازی فرایند آموزش و بهبود عملکرد مدلهای زبانی بزرگ انجام دهید.

هزینههای پایین

اگر سختافزار لازم را داشته باشید، اجرای آن بهصورت محلی میتواند ارزانتر از پرداخت هزینههای ابری باشد.

کاهش تأخیر

اجرای یک مدل زبانی بزرگ روی سختافزار شخصی میتواند مزایای قابلتوجهی از نظر تأخیر داشته باشد که به کاهش زمان پاسخگویی میان ارسال درخواست و دریافت پاسخ از مدل میانجامد. این جنبه اهمیت زیادی دارد، بهویژه در برنامههایی مانند چتباتها یا خدمات ترجمه زنده که بهشدت بر پاسخهای بلادرنگ تکیه دارند.

حریم خصوصی بیشتر

با آموزش و اجرای مدلهای زبانی بزرگ بهصورت محلی، شما کنترل بیشتری بر دادهها و مدلهای خود پیدا میکنید که این امکان را به شما میدهد تا محافظتهای قویتری برای حفاظت از اطلاعات حساس ایجاد کنید.

معایب اجرای مدلهای زبانی بزرگ بهصورت محلی

در اینجا برخی از معایب اجرای مدلهای زبانی بزرگ بهصورت محلی آورده شده است:

هزینههای اولیه بالاتر

راهاندازی سرورهای محلی برای اجرای مدلهای زبانی بزرگ میتواند هزینهبر باشد، اگر سختافزار و نرمافزار پیشرفته نداشته باشید.

پیچیدگی

اجرای مدلهای زبانی بزرگ بهصورت محلی میتواند چالشبرانگیز، زمانبر باشد و بار عملیاتی داشته باشد. قسمتهای زیادی وجود دارد و شما باید هم نرمافزار و هم زیرساخت را راهاندازی و نگهداری کنید.

محدودیت در مقیاسپذیری

شما نمیتوانید با افزایش تقاضا مقیاس مدل را افزایش دهید. اجرای چندین مدل زبانی بزرگ ممکن است نیازمند قدرت محاسباتی بیشتری از آنچه باشد که در یک ماشین ممکن است.

دسترسی در زمان خرابی

سرورهای محلی کمتر مقاوم هستند. در صورت بروز خرابیهای سیستم، دسترسی به مدلهای زبانی بزرگ شما به خطر میافتد. همچنین پلتفرمهای ابری با چندین لایه پشتیبانی از قبل، کمتر دچار خرابی میشوند.

دسترسی به مدلهای آموزشدیده

دسترسی به جدیدترین مدلهای زبانی بزرگ پیشرفته برای تنظیم دقیق و استقرار ممکن است بهراحتی در دسترس شما نباشد.

برای آشنایی بیشتر با مدل مولد این مطلب را مطالعه کنید:

مدل مولد یا Generative Model چیست؟

عوامل مهم نحوه مستقرسازی هوش مصنوعی مولد

برای مستقرکردن هوش مصنوعی مولد باید این موارد را در نظر گرفت:

نیازهای مقیاسپذیری

چه تعداد کاربر فعلی دارید و چه تعداد مدل نیاز است تا بتوانید نیازهای مدنظر را برآورده کنید؟ علاوهبراین، آیا برنامهریزی برای استفاده از دادهها بهمنظور بهبود مدل را دارید؟ این اطلاعات تعیین میکند آیا نیاز به یک راهحل مبتنی بر ابر است یا خیر.

الزامات حریم خصوصی و امنیت دادهها

آیا در حوزهای فعالیت میکنید که حفظ حریم خصوصی کاربران و حفاظت از دادهها از اهمیت بالایی برخوردار است؟ آیا قوانین سختگیرانه حریم خصوصی دادهها یا خطمشیهای سازمانی وجود دارد؟ اگر پاسخ مثبت است، لازم است که یک استقرار Local توسعه یابد.

محدودیتهای هزینه

اگر با بودجه محدودی کار میکنید و به سختافزاری دسترسی دارید که میتواند وظایف را انجام دهد، اجرای مدلها بهصورت محلی ممکن است از نظر هزینهای مقرونبهصرفهتر باشند.

سهولت استفاده

اگر مهارتهای فنی پایینتری دارید یا تیم محدودی دارید، مستقرسازی و مدیریت مدلها میتواند چالشبرانگیز باشد. در چنین مواردی، پلتفرمهای ابری اغلب ابزارهای آمادهبهکاری را ارائه میدهند که فرایند را سادهتر و قابلمدیریتتر میکند.

نیاز به مدلهای جدیدتر

آیا به هوش مصنوعی مولد دسترسی دارید؟ پلتفرمهای ابری معمولاً دسترسی به جدیدترین مدلهای پیشرفته را فراهم میآورند تا از قابلیتهای پیشرفتهترین موجود بهرهمند شوید.

قابلیت پیشبینی

شما میتوانید هزینه زیرساختهای محلی را مدیریت کنید. این امر به شما امکان میدهد تا بودجه را پیشبینی کنید، در مقابل هزینههای متغیر مرتبط با استفاده از خدمات ابری.

مسائل انحصار توسط توسعهدهنده ابر

زیرساختهای محلی این خطر انحصار را کاهش میدهند اما نیاز به نگهداری بیشتری دارند.

تحمل تأخیر شبکه

اگر برنامه شما به پاسخهای Real-Time و تأخیر کمتر نیاز دارد، انتخاب یک تنظیمات محلی بهترین انتخاب برای دستیابی به عملکرد مدنظر است.

تخصص تیم

اگر تیم شما از قبل با ابزارها و خدمات ابری آشناست، انتخاب گزینه ابری بهترین انتخاب است. اجرای یک راهحل جدید و یادگیری ابزارهای جدید میتواند هزینههایی را از نظر زمان، پول و منابع انسانی به همراه داشته باشد.

بهطور خلاصه:

- کسبوکارهایی با محدودیتهای بودجه یا تمایل به کنترل بیشتر میتوانند انتخاب کنند که هوش مصنوعی مولد را به صورت محلی اجرا کنند.

- کسبوکارهایی که به دنبال راهحلهای مستقرسازی هوش مصنوعی مولد ساده و سهولت استفاده هستند، میتوانند ابر را انتخاب کنند.

در ادامه با ۸ مدل زبانی بزرگ منبع باز آشنا شوید.

۸ مدل زبانی بزرگ منبع باز برتر برای سال ۲۰۲۴

برترین مدلهای زبانی بزرگ منبع باز در سال ۲۰۲۴ از این قرار است:

LLaMA 2

در جولای ۲۰۲۳ LLaMA 2 برای استفادههای تحقیقاتی و تجاری معرفی شد. این مدل متنی مولد پیشآموزشدیده با ۷ تا ۷۰ میلیارد پارامتر، با استفاده از یادگیری تقویتی از بازخورد انسانی (RLHF)، بهینهسازی شده است. این مدل متنی مولد که میتوان از آن بهعنوان چتبات استفاده کرد قابلیت سازگاری با انواع وظیفههای پردازش زبان طبیعی و برنامهنویسی را دارد. متا دو نسخه باز و سفارشیشده از LLaMA 2، یعنی چت لاما و کد لاما، را راهاندازی کرده است.

برای آشنایی بیشتر با لاما این مطلب را مطالعه کنید:

مدل LLaMA متا AI چیست؟ LLaMA چه مزیتی بر ChatGPT دارد؟

BLOOM

بلوم در سال ۲۰۲۲ پس از یک همکاری بینالمللی یکساله با داوطلبانی از بیش از ۷۰ کشور جهان و متخصصان هاگینگ فیس به دنیا معرفی شد. این مدل زبانی با استفاده از منابع محاسباتی در مقیاس بزرگ روی دادههای متنی عظیمی آموزش دیده است.

عرضه بلوم گامی بزرگ در جهت دموکراتیککردن دسترسی به تکنولوژیهای نوآورانه هوش مصنوعی مولد بود. با بیش از ۱۷۶میلیارد پارامتر بلوم اکنون بهعنوان یکی از قدرتمندترین مدلهای زبانی منبعباز شناخته میشود که توانایی ایجاد متون منسجم و دقیق را در ۵۹ زبان مختلف و ۱۳ زبان برنامهنویسی دارد. استفاده از بلوم ازطریق پلتفرم هاگینگ فیس بهطور کاملاً رایگان امکانپذیر است.

BERT

فناوری پایهای که مدلهای زبانی بزرگ مانند برت بر آن استوارند معماری نوینی بهنام ترنسفورمر است. این فناوری در سال ۲۰۱۷ توسط محققان گوگل و در مقالهای با عنوان «توجه، تنها چیز مورد نیاز است» توسعه یافت. برت یکی از نخستین آزمایشهایی بود که قابلیتهای این معماری را به نمایش گذاشت.

گوگل در سال ۲۰۱۸ برت را بهعنوان یک LLM منبعباز و پیشرفته روانه بازار کرد که بهسرعت در بسیاری از کاربردهای پردازش زبان طبیعی به عملکردی بیسابقه دست یافت. همچنین با ویژگیهای نوآورانهاش در روزهای نخست، به یکی از محبوبترین و پرکاربردترین مدلهای زبانی تبدیل شد. اکنون هزاران مدل برت منبع باز، رایگان و آموزشدیده برای کاربردهای خاص مانند تحلیل احساسات، بررسی یادداشتها یا شناسایی نظرات توهینآمیز در دسترس هستند.

Falcon 180B

فالکون ۴۰۸ قبلتر توانسته بود نظر جامعه هوش مصنوعی متنباز را به خود جلب کند و در صدر جدول ردهبندی Hugging Face قرار گیرد. با عرضه فالکون 180B، داستان جدیدی از رقابت نزدیک میان مدلهای اختصاصی و متنباز رقم خورد.

این محصول در سپتامبر ۲۰۲۳ توسط موسسه نوآوری فناوری امارات متحده عربی معرفی شد. Falcon 180B با ۱۸۰ میلیارد پارامتر و ۳.۵ تریلیون توکن آموزش دیده و نشان داد که قدرت محاسباتی فوقالعادهای دارد. همچنین در انجامدادن وظایف مختلف پردازش زبان طبیعی (NLP)، عملکردی بهتر از LLaMA 2 و GPT-3.5 ارائه داده و حتی میتواند با PaLM2 گوگل رقابت کند. گرچه استفاده از این مدل برای اهداف تجاری و پژوهشی رایگان است، باید به خاطر داشت که به منابع محاسباتی بزرگی نیاز دارد.

OPT-175B

با رونمایی از OPT-175B در سال ۲۰۲۲ متا نشان داد که در نظر دارد با بازکردن دسترسی به مدلهای زبانی ترانسفورمر پیشآموزشدیده (OPT)، مسیر نوآوری در عرصه LLM را هموار کند. این مجموعه شامل ترانسفورمرهایی با تنوع گستردهای از ۱۲۵ میلیون تا ۱۷۵ میلیارد پارامتر است و قابلیتهایی مشابه با GPT-3 را ارائه میکند. این مدل تحت یک مجوز غیرتجاری عرضه شده و فقط برای استفادههای پژوهشی قابلاستفاده است.

XGen-7B

هر روز شرکتهای بیشتری به رقابت مدلهای زبانی بزرگ (LLM) وارد میشوند. یکی از آخرین شرکتهایی که به این عرصه پا گذاشت Salesforce بود که در جولای ۲۰۲۳ مدل زبانی بزرگ خود را با نام XGen-7B راهاندازی کرد.

اکثر LLMهای متنباز روی ارائه پاسخهای طولانی با اطلاعات محدود (یعنی پرسشهای کوتاه با کمترین زمینه) تمرکز دارند. ایده پشت XGen-7B ساخت ابزاری است که پنجرههای زمینهای طولانیتر را پشتیبانی کند. بهویژه، پیشرفتهترین نوع XGen (XGen-7B-8K-base) امکان یک پنجره زمینه 8K را فراهم میکند، یعنی اندازه تجمعی متن ورودی و خروجی.

کارآمدی نیز اولویت دیگری در XGen است که فقط از ۷میلیارد پارامتر برای آموزش استفاده میکند، بسیار کمتر از بیشتر LLMهای قدرتمند متنباز، مانند LLaMA 2 یا Falcon.

XGen با وجود اندازه نسبتاً کوچک خود همچنان میتواند نتایج عالی ارائه کند. این مدل برای اهداف تجاری و تحقیقاتی در دسترس است، بهجز نسخههای XGen-7B-{4K,8K} که با دادههای آموزشی و RLHF آموزش دیدهاند و تحت لیسانس غیرتجاری منتشر شدهاند.

GPT-NeoX و GPT-J

GPT-NeoX و GPT-J که توسط محققان EleutherAI یک آزمایشگاه تحقیقاتی غیر انتفاعی هوش مصنوعی توسعه یافته است، دو جایگزین منبعباز عالی برای GPT هستند.

GPT-NeoX دارای ۲۰ میلیارد پارامتر است، درحالیکه GPT-J دارای ۶ میلیارد پارامتر است. اگرچه بیشتر LLMهای پیشرفته با بیش از ۱۰۰ میلیارد پارامتر آموزش میبینند، این دو LLM همچنان میتوانند نتایجی با دقت بالا ارائه کنند.

GPT-NeoX و GPT-J با ۲۲ مجموعه داده با کیفیت بالا از منابع متنوع آموزش دیدهاند که استفاده از آنها را در حوزههای مختلفی ممکن میکند. تمامی وظایف پردازش زبان طبیعی، از تولید متن و تحلیل احساسات گرفته تا توسعه تحقیقات و کمپینهای بازاریابی، میتواند با GPT-NeoX و GPT-J انجام شود. هر دو LLM ازطریق API بهصورت رایگان در دسترس هستند.

Vicuna 13-B

Vicuna-13B یک مدل گفتوگویی متنباز است که با تنظیم دقیق مدل LLaMa 13B و استفاده از گفتوگوهای بهاشتراکگذاشتهشده کاربران از ShareGPT آموزش دیده است.

کاربردهای Vicuna-13B بهعنوان یک چتبات هوشمند بیشمار است و در صنایع مختلف از آن استفاده میشود. یک ارزیابی اولیه با استفاده از GPT-4 بهعنوان داور نشان داد که Vicuna-13B بیش از ۹۰ درصد کیفیت ChatGPT و Gemini را دارد و در بیش از ۹۰ درصد موارد از دیگر مدلها مانند LLaMA و Alpaca پیشی گرفت.

انتخاب مناسبترین LLM براساس نیازهای شما

دنیای مدلهای زبانی بزرگ (LLM) با منبع باز در حال گسترش چشمگیری است. امروزه شاهد هستیم که تعداد این مدلهای منبع باز از نسخههای اختصاصی پیشی گرفته است و با پیشرفتهایی که توسط برنامهنویسان از سراسر جهان صورت میگیرد، به نظر میرسد که این فاصله عملکردی بهزودی از بین برود؛ زیرا آنها برای بهبود مدلهای موجود و خلق نسل جدیدی از LLMهای کارآمدتر دست به همکاری زدهاند.

در این عرصه پویا و هیجانانگیز یافتن مدل LLM منبع بازی که دقیقاً با نیازهای شما جور در بیاید، میتواند کمی چالشبرانگیز باشد. در ادامه چندین عامل کلیدی را برای در نظر گرفتن پیش از انتخاب یک LLM منبع باز مشخص میکنیم:

هدف شما چیست؟

این اولین سوالی است که باید از خود بپرسید. مدلهای LLM منبعباز همیشه در دسترس هستند، اما برخی از آنها فقط برای هدفهای تحقیقاتی منتشر میشوند. بنابراین اگر قصد دارید شرکتی را راهاندازی کنید، باید از محدودیتهای احتمالی مجوز آگاه باشید.

چرا به یک LLM نیاز دارید؟

این نیز بسیار مهم است. LLMها در حال حاضر بسیار محبوب هستند. همه درمورد آنها و فرصتهای بیپایانشان صحبت میکنند، اما اگر میتوانید ایده خود را بدون نیاز به LLMها پیادهسازی کنید، پس از آنها استفاده نکنید. استفاده از آنها اجباری نیست (و احتمالاً هزینه زیادی را صرفهجویی و از استفاده بیشتر منابع جلوگیری میکنید).

به چقدر دقت نیاز دارید؟

این جنبه مهمی است. رابطه مستقیمی میان اندازه و دقت مدلهای LLM پیشرفته وجود دارد. این بهآن معناست که بهطور کلی، هر چه LLM از نظر پارامترها و دادههای آموزشی بزرگتر باشد، مدل دقیقتر خواهد بود. بنابراین اگر به دقت بالا نیاز دارید، باید به دنبال LLMهای بزرگتری باشید، مانند LLaMA یا Falcon.

چقدر مایل به سرمایهگذاری هستید؟

این سؤال به سؤال قبلی ارتباط نزدیکی دارد. هر چه مدل بزرگتر باشد، منابع بیشتری برای آموزش و بهرهبرداری از مدل نیاز است. این بهمعنای نیاز به زیرساختهای اضافی برای استفاده یا صورتحساب بیشتر از ارائهدهندگان ابری در صورتی است که بخواهید LLM خود را در ابر به کار ببرید. LLMها ابزارهای قدرتمندی هستند، اما حتی مدلهای منبعباز نیز برای استفاده از آنها به منابع قابل توجهی نیاز دارند.

آیا میتوانید با یک مدل ازپیشآموزشدیده به اهداف خود برسید؟

وقتی میتوانید از یک مدل آموزشدیده از پیش استفاده کنید، چرا پول و انرژی خود را برای آموزش LLM از ابتدا صرف کنید؟ نسخههای زیادی از LLMهای منبعباز آموزش دیده برای یک هدف استفاده خاص وجود دارد. اگر خواسته شما در یکی از این موارد استفاده قرار میگیرد، از مدلهای آماده استفاده کنید.

نتیجهگیری

با توجه به تکامل سریع مدلهای زبانی متنباز، به نظر نمیرسد که فضای هوش مصنوعی مولد لزوماً توسط غولهای فناوری که توانایی ساخت و استفاده از این ابزارهای قدرتمند را دارند انحصاری شود. ما در این مطلب فقط ۸ مدل زبانی متن باز را بررسی کردیم، اما تعداد آنها بسیار بیشتر است و بهسرعت در حال افزایش هستند.

پرسشهای متداول

چرا استفاده از LLMهای منبع باز برای کسبوکارها توصیه میشود؟

استفاده از LLMهای منبع باز امکان کنترل بیشتر بر دادهها و فرایندهای آموزشی را فراهم میآورد، هزینهها را کاهش میدهد و انعطافپذیری بیشتری برای سفارشیسازی و توسعه مدلها براساس نیازهای خاص کسبوکار فراهم میکند.

چگونه LLMهای منبع باز به حفظ حریم خصوصی کمک میکنند؟

با استفاده از LLMهای منبع باز سازمانها میتوانند کنترل کاملی بر دادههای خود داشته باشند، از نشت اطلاعات جلوگیری کنند و اطمینان حاصل کنند که دادهها در چارچوب قوانین حفاظت از دادهها و حریم خصوصی مدیریت میشوند.

چه تفاوتهایی میان LLMهای منبع باز و مدلهای انحصاری وجود دارد؟

تفاوت اصلی در دسترسی به کد منبع و امکان سفارشیسازی است. LLMهای منبع باز شفافیت بیشتری ارائه میکنند و اجازه میدهند تا توسعهدهندگان بر اساس نیازهای خود مدلها را تنظیم و بهبود ببخشند.

چگونه میتوان از LLMهای منبع باز برای نوآوری در هوش مصنوعی بهره برد؟

LLMهای منبع باز با فراهمآوردن دسترسی به کد و امکانات سفارشیسازی، زمینهساز نوآوری و خلاقیت هستند. جامعه توسعهدهندگان میتواند با همکاری و اشتراکگذاری دانش، به بهبود و ایجاد نسل جدیدی از مدلها کمک کند.

چه چالشهایی در استفاده از LLMهای منبع باز وجود دارد و چگونه میتوان آنها را مدیریت کرد؟

چالشهای اصلی شامل نیاز به منابع سختافزاری قوی، مدیریت و نگهداری پیچیده مدلها و همینطور اطمینان از امنیت دادهها. برای مقابله با این چالشها، سازمانها میتوانند با سرمایهگذاری در زیرساختهای مناسب، استفاده از ابزارها و روشهای امنیتی پیشرفته و همچنین همکاری با جامعه بزرگتر توسعهدهندگان برای بهاشتراکگذاری بهترین شیوهها و راهکارها این چالشها را مدیریت کنند.

یادگیری ماشین لرنینگ را از امروز شروع کنید!

دنیای دادهها جذاب است و دانستن علم داده، توانایی تحلیل داده یا بازاریابی مبتنی بر داده، شما را برای فرصتهای شغلی بسیاری مناسب میکند. فارغ از رشته و پیشزمینه تحصیلی و شغلی، میتوانید یادگیری این دانش را همین امروز شروع کنید و آن را از سطح مقدماتی تا پیشرفته بیاموزید. اگر دوست دارید به این حوزه وارد شوید، پیشنهاد میکنیم با کلیک روی این لینک قدم اول را همین حالا بردارید.

مشاوران کافهتدریس به شما کمک میکنند مسیر یادگیری برای ورود به این حوزه را شروع کنید: